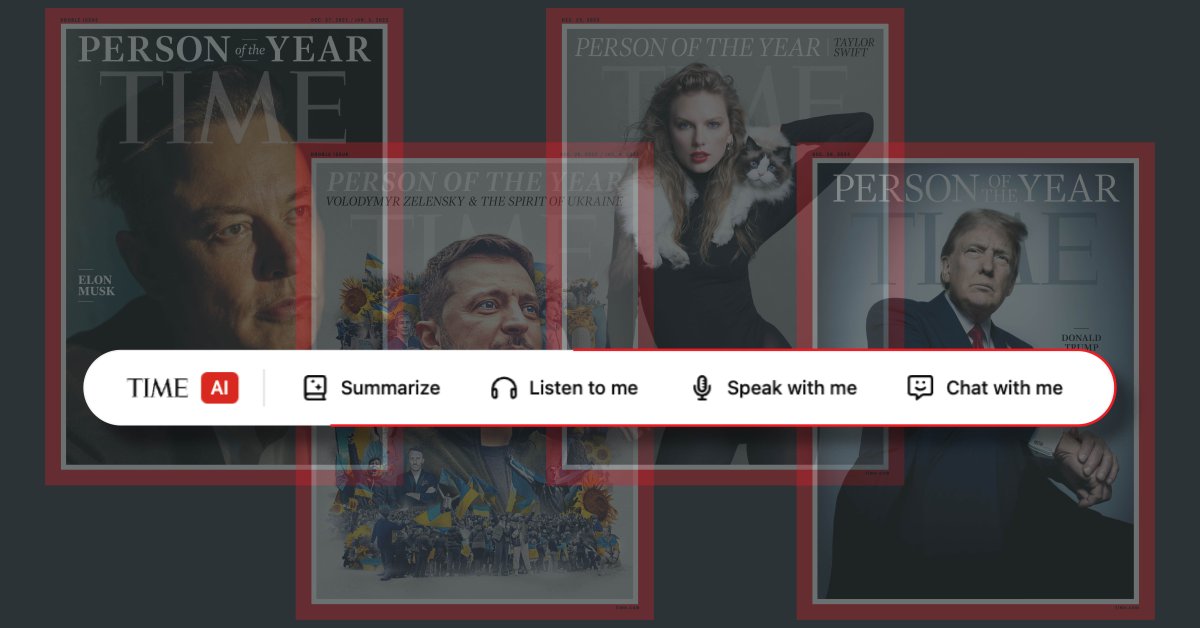

pagEl Jugador del Año es una de nuestras franquicias más duraderas. Cada año, nuestro objetivo es nombrar a una persona del año: la persona, grupo o idea que tuvo el mayor impacto en el mundo en los 12 meses anteriores. Con el lanzamiento de este año, queríamos hacer algo que reflejara el cambio reciente en la forma en que interactuamos con la información y las noticias.

Nuestro objetivo era crear un chatbot de IA específicamente diseñado para la Persona del Año de TIME (pasado o presente) basado en un cuerpo seleccionado de artículos verificados de TIME, otras fuentes confiables y el conocimiento general incorporado del bot. Este chatbot está diseñado para brindar respuestas enfocadas, confiables y precisas mientras mantiene un tono seguro y profesional. Está diseñado para evitar que los usuarios dirijan la conversación hacia temas no relacionados, controvertidos o potencialmente sesgados.

El chatbot de IA de Time representa un importante paso adelante en el uso de la IA para mejorar el periodismo Con su recuperación de contenido optimizada y enfocada, el chatbot tiene como objetivo brindar una experiencia segura, precisa y atractiva para los lectores. Esta herramienta ejemplifica cómo la innovación puede respaldar y ampliar la presentación de informes fiduciarios.

He aquí un vistazo más de cerca a cómo funciona.

¿Qué es el chatbot de IA de Time?

Es una herramienta interactiva diseñada para ayudar a los lectores a explorar el paquete Persona del año de TIME. Basado en artículos verificados, el chatbot proporciona información precisa y detallada sobre personas de años pasados y presentes. A diferencia de las herramientas típicas de IA, está diseñada para conversaciones significativas y enfocadas sobre un solo aspecto del periodismo de TIME. Combina precisión, profundidad e interactividad de una manera que se alinea con el compromiso de TIME de brindar informes honestos. Al hacer que la cobertura de la Persona del Año sea más interactiva, los chatbots profundizan la participación y la accesibilidad de los lectores.

¿Cómo nos aseguramos de que el chatbot proporcione información precisa?

Las respuestas del sistema se basan en contenido verificado de artículos de TIME y otras fuentes confiables, todo ello para cumplir con estrictos estándares periodísticos. El objetivo es evitar especulaciones y mantener la conversación dentro del alcance de la experiencia del chatbot.

¿Cómo manejan los chatbots la información incorrecta?

Al limitar su material fuente a artículos y fuentes aprobados, el chatbot reduce el riesgo de difundir información inexacta o no verificada. Si una pregunta se adentra en un territorio controvertido, redirige la conversación hacia temas seguros y basados en hechos. Esto educadamente devuelve la conversación a su propósito original de explorar el paquete Persona del Año de Time.

¿Qué tipo de preguntas pueden hacer los lectores?

Los lectores pueden preguntar sobre una serie de temas, que incluyen:

- Antecedentes de la Persona del Año anteriormente nombrada

- Contexto histórico de los vastos archivos de TIME

- Detalles y conocimientos de la cobertura relacionada de TIME

¿De dónde provienen los datos del chatbot?

Su conocimiento se deriva de lo siguiente:

- Mejor ensayo del año según Time

- Informes TIME relacionados

- Archivos históricos

- Conocimiento común integrado en grandes modelos de lenguaje (LLM).

¿Qué medidas de seguridad existen?

El chatbot emplea un sistema de seguridad de doble capa:

- guardel (Puntuación de seguridad, lógica, respuestas alternativas) Asegúrese de que las entradas sean seguras y relevantes. Vea más barandillas a continuación.

- Contenido enfocado Limita la respuesta del elemento TIME validado.

¿Cómo funciona?

El sistema emplea una combinación Tres estrategias:

- incitación Establece un marco sobre cómo funcionará el chatbot durante la interacción del usuario.

- recuperación Garantiza que el chatbot se base en artículos verificados de TIME, ya sea directamente o mediante resúmenes generados.

- anillado Clasifica las entradas del usuario como seguras o inseguras, redirigiendo las respuestas según sea necesario para mantener el enfoque y la integridad.

El sistema chatbot integra varios componentes, como se ilustra a continuación:

- Procesando la entrada del usuario: Cada mensaje de usuario, junto con el historial de conversaciones, es analizado mediante dos modelos: el chatbot básico y el modelo Railing.

- Evaluación de Guardel: El modelo de barrera determina si el mensaje es seguro de procesar. Si se considera seguro, el chatbot principal genera una respuesta. De lo contrario, el modelo Guardrail proporciona una respuesta alternativa que está diseñada precisamente para redirigir o resolver el problema.

¿Por qué utilizar dos modelos?

Un modelo único que maneje todas las tareas enfrentará rápidamente desafíos debido a la complejidad. Los modelos de lenguajes grandes (LLM) luchan por seguir consistentemente instrucciones complejas y de múltiples capas. Al dividir la responsabilidad entre el chatbot principal y el modelo Railing, el sistema mantiene una alta precisión y confiabilidad.

Imagen aquí

Configuración básica del chatbot

El chatbot inicial, basado en el modelo mini GPT 4o, está optimizado para responder preguntas sobre la Persona del Año de TIME basándose en contenido seleccionado. Las indicaciones del sistema indican al chatbot que se base en el artículo principal y en los artículos complementarios al crear su respuesta.

Además de los artículos de TIME, también utiliza chatbots. Abreviatura Y Llamada de herramientas Para recuperar información relevante dinámicamente:

- Resumen: Los puntos clave de los artículos están condensados e incluidos en el contexto del modelo para una referencia rápida.

- Llamando a la herramienta: Dependiendo de la conversación, el chatbot puede recuperar detalles adicionales haciendo referencia a artículos específicos a través de resúmenes generados artificialmente. Permite respuestas precisas y contextuales al tiempo que reduce la sobrecarga de información.

Configuración del modelo de faja

El modelo de barandilla basado en GPT 4o Mini actúa como filtro de seguridad. Su sistema solicita establecer límites para las entradas aceptables, asegurando que las conversaciones sigan siendo relevantes y apropiadas. Para cada mensaje de usuario, genera:

- A Puntuación de seguridad Indica el nivel de riesgo de entrada,

- A lógica Explica por qué la entrada se considera segura o insegura, y

- un opcional respuestas alternativas Para mensajes no seguros.

Según la puntuación de seguridad, el sistema dirige la entrada al chatbot principal o proporciona respuestas alternativas a Guardel.